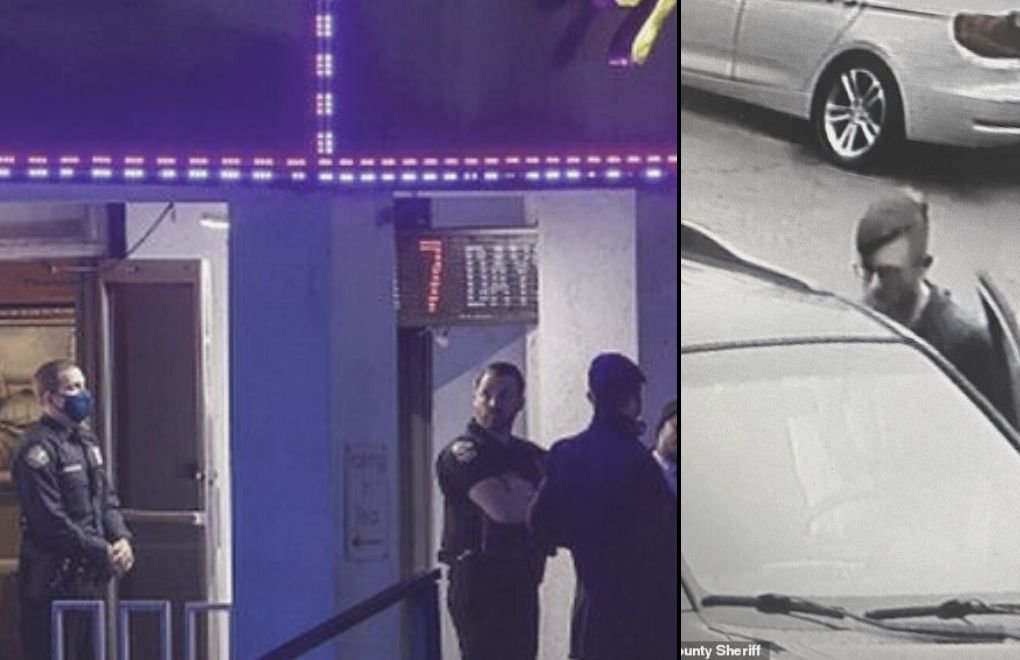

*Fotoğraflar: Cheeroke polis departmanı.

Haberin Kürtçesi için tıklayın

Atlanta çevresindeki masaj salonlarına yapılan üç silahlı saldırı, sekiz kişinin hayatını kaybetmesine neden oldu.

Yerel saatle Salı akşamüstü iki saatlik bir süre içinde üç masaj salonuna yapılan saldırılarda ilk olarak şehrin kuzeyindeki Young's Asian Massage'da iki Asyalı kadın, bir beyaz kadın ve bir beyaz adam öldürüldü.

Ardından Gold Spa'da üç Asyalı kadın, Aromaterapi Spa'da bir Asyalı kadın vurularak öldürüldü.

Saldırı zanlısını tespit eden ilk kamera görüntüsü, Atlanta'dan 30 mil uzakta, Georgia, Acworth, Bells Ferry Road ve Highway 92 açıklarındaki Young's Asian Massage salonunda saat 17:00'den önce kaydedildi.

TIKLAYIN - Ayrımcılık Salgını Daha Hızlı Yayılıyor: Ben Virüs Değilim

"Pizza, silahlar ve Tanrı"

21 yaşındaki saldırgan yaklaşık üç saat sonra Georgia'ınn güneybatısında yakalandı.

21 yaşındaki saldırgan yaklaşık üç saat sonra Georgia'ınn güneybatısında yakalandı.

Şüphelinin Instagram hesabındaki şu not ABD basınında öne çıkarılan ayrıntılardan oldu:

"Pizza, silahlar, ritim, müzik, aile ve Tanrı. Oldukça iyi bir hayat."

2017'de şüpheli ile aynı liseye giden bir öğrenci Daily Beast'e yaptığı açıklamada, şüphelinin uzun süredir dine meraklı olduğunu ancak hiç şiddet meyillisi görünmediğini söyledi.

Şüphelinin babasının Crabapple First Baptist Kilisesi'nde bir pastör olduğu ortaya çıktı.

"Trump Asyalılara ayrımcılığı artırdı"

Geçen hafta Başkan Joe Biden, koronavirüs salgınının başlangıcından bu yana Asyalı Amerikalılara karşı işlenen suçları 'vahşi nefret suçları' olarak tanımlayarak kınadı.

Geçen hafta Başkan Joe Biden, koronavirüs salgınının başlangıcından bu yana Asyalı Amerikalılara karşı işlenen suçları 'vahşi nefret suçları' olarak tanımlayarak kınadı.

Biden bu tür eylemleri 'Amerikan dışı' olarak nitelendirdi ve durdurulmasını talep etti.

Demokrat cumhurbaşkanı, Çin'de ortaya çıkan salgın nedeniyle "saldırıya uğrayan, taciz edilen, suçlanan ve günah keçisi verilen Asyalı Amerikalılara karşı kötü nefret suçlarını" kınadı.

Aktivistler, daha geniş Asya karşıtı ayrımcılığın, eski başkan Donald Trump ve diğerlerinin virüsten "Çin virüsü" olarak bahsetmesi ve sürekli Çin'i hedef almasıyla arttığını söylüyor.

Pandemi öncesinden iki kat fazla

Kaliforniya ve New York, Asya karşıtı ırkçılıkla mücadeleye daha fazla kaynak ayırmaya başladı.

California Eyaleti resmi verilerine göre göre, New York ve Los Angeles dahil olmak üzere Asya karşıtı nefret suçları 16 büyük ABD şehrinde geçen yıl 49'dan 122'ye yükseldi. Hatta buna oranla, diğer gruplara yönelik nefret suçu düştü.

Tüm nefret suçlarını saptamadığı düşünülen rakamlar pandemi öncesine göre Asyalıların en az iki kat fazla ayrımcılığa maruz kaldığını gösteriyor.

(PT)